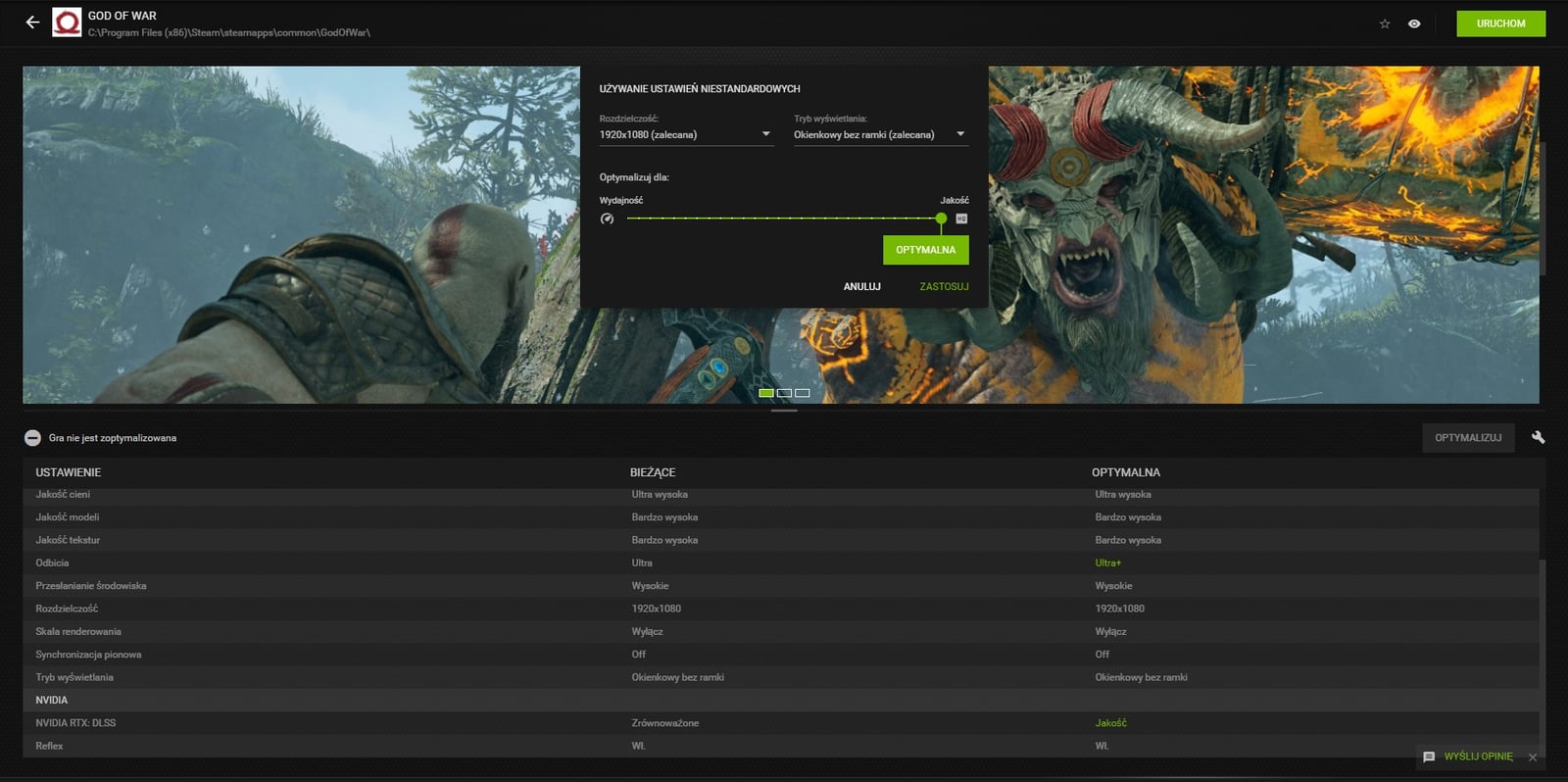

Ustawienia obejmują zwykle podział na te dotyczące bezpośrednio ekranu, jak i grafiki per se, choć to bardzo płynny podział, którego producenci niespecjalnie respektują. Znacznie lepiej podzielić je na te podstawowe i dodatkowe (zaawansowane), choć i tak obecnie większość z gier możecie ustawić automatycznie.

Użyć do tego możecie zwłaszcza predefiniowanych ustawień (Niskie, Średnie, Wysokie, Ultra) albo tych bardziej zaawansowanych, biorących pod uwagę dokładną konfigurację Waszego sprzętu. Ten zresztą jest najczęściej rozpoznawany już przy pierwszym uruchomieniu gry, która stara się dopasować ustawienia, ale nie wychodzi jej to zwykle najlepiej.

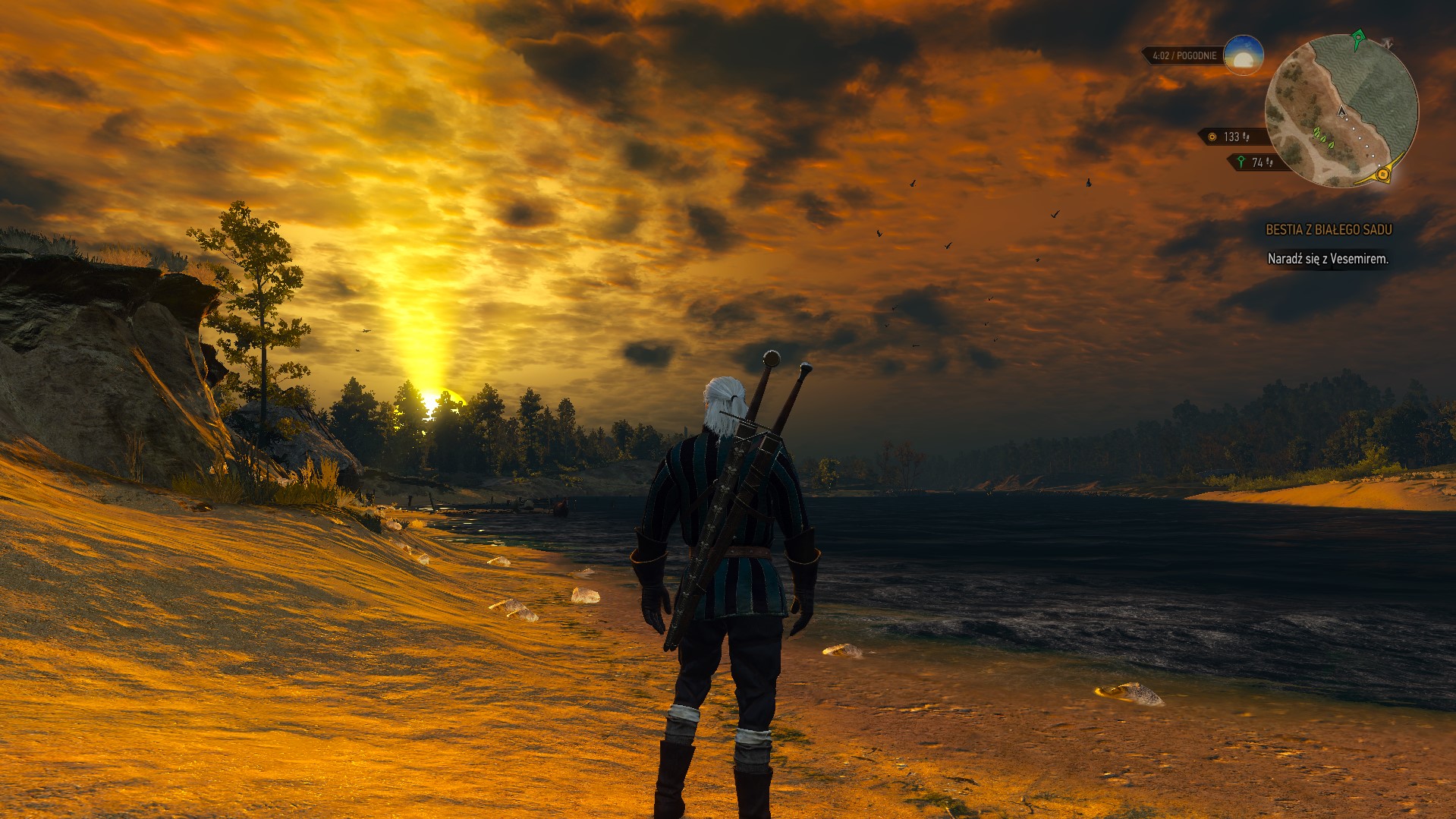

Chociaż mogłoby się wydawać, że gry będą miały bardzo podobne ustawienia graficzne, to dotyczy to tylko tych najważniejszych. Niektóre tytuły rezygnują z poszczególnych wodotrysków, inne implementują je na stałe bez możliwości dezaktywacji, a jeszcze inne ukrywają je za ścianą własnych fantazyjnie nazywanych opcji. Dlatego podzieliliśmy ten artykuł poradnikowy na fragment dotyczący tych najważniejszych ustawień, które spotkacie praktycznie wszędzie, jak i tych bardziej “unikalnych”, posiłkując się kilkoma grami AAA.

Podstawowe opcje graficzne w grach

Rozdzielczość w grach

Zacznijmy od zdecydowanie najważniejszej opcji, czyli rozdzielczości. Gry zwykle od razu odczytują natywną rozdzielczość naszego monitora i nigdy tej opcji nie tykamy. Oczywiście nie bez powodu, bo to właśnie ona przede wszystkim odpowiada za jakość wyświetlanego obrazu. Obecnie możemy zauważyć trend odchodzenia od rozdzielczości Full HD (1920×1080) na rzecz 1440p (2560 × 1440) i 4K (4096 × 2160), co ma sens zwłaszcza w momencie, kiedy w grę wchodzą większe ekrany (rzędu 27-, czy 32-cali, a nie typowych 22/24-cali).

Musicie wiedzieć, że rozdzielczość wyraża to, jak wiele pikseli buduje dany ekran i każdy z tych pikseli trzeba jakoś wypełnić. Tak więc, tradycyjne Full HD oznacza, że każda jedna linia pionowa pikseli (najmniejszej części składowej) liczy aż 1920 z nich. To oznacza, że monitor Full HD składa się z ponad 2 milionów pikseli, a 4K z około 8,85 milionów, przez co w tym drugim przypadku karta graficzna musi wykonać (w uproszczeniu) około 4 razy więcej pracy. Jeśli więc odpalicie grę w Full HD na monitorze 4K, to zobaczycie paskudną wręcz mozaikę, bo jeden piksel wirtualny (wyrenderowany) będzie reprezentowany przez ponad 4 rzeczywiste.

Zwiększając wielkość ekranu, rosną również piksele i to wyjaśnia, dlaczego tak ważnym parametrem jest gęstość pikseli na cal, która sprawia, że nawet handheldy z 7-calowym ekranem 720p mogą oferować tak wysoką jakość, jak większe monitory 4K. Oczywiście te różnice “wygładza” to, jak daleko znajdują się od tych ekranów nasze oczy.

Proporcje ekranu w grach

Zyskujące na popularności zakrzywione i panoramiczne ekrany, a nawet gamingowe laptopy sprawiają, że tradycyjne proporcje 16:9 dorobiły się konkurentów wszelakiej maści. Na tę opcję zwykle nie mamy większego wpływu, bo gra albo nie wspiera niestandardowych proporcji, co powoduje “czarne pasy” po bokach, albo (idealnie) ustala je z góry, uwzględniając po prostu rozdzielczość ekranu, bo to właśnie ona odpowiada za dane proporcje i tak też 1920:1080 po podzieleniu przez 120 da nam wspomniane 16:9.

Gry pozwalają też wybrać ekran, na którym mają się wyświetlać, co w dobie wielomonitorowych konfiguracji nie dziwi. Pamiętajcie jednak, że nawet odpalony obok monitor wyświetlający pulpit zabiera cenne zasoby sprzętowe i tym samym obniża płynność gry. Rozwiązanie? Windows+P>”Tylko ekran komputera” i można grać bez potrzeby wyłączania dodatkowego monitora.

Ograniczenie FPS w grach

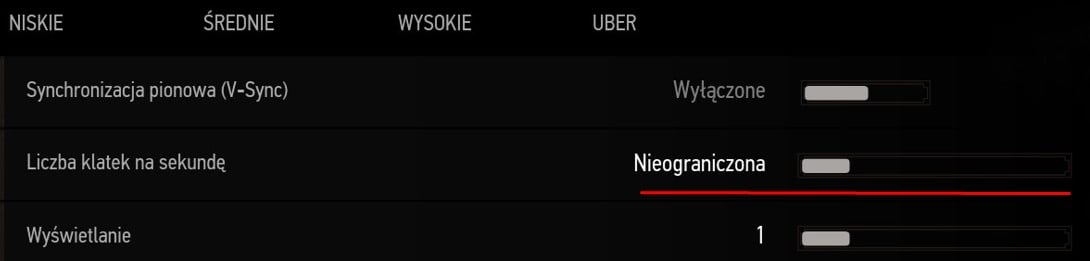

Do tej pory pamiętam, jak po zakupie nowej karty graficznej przeraziłem się, włączając starszą grę, która dała jej wycisk w samym menu. Powód? Na całe szczęście nie wadliwy model, a brak ograniczenia FPSów w grach, które jakimś sposobem zniosłem w .configu gry. Dziś w menu większość gier ma już blokady na zwykle 30 lub 60 FPS, których nie można zmienić.

Sprawa ma się inaczej z klatkami na sekundę w samej rozgrywce. Dziś gry, które nie ograniczamy V-Syncem (o tej technologii zdecydowanie warto zapomnieć) pozwalają nam zablokować FPS na tradycyjne poziomy odświeżania monitorów. Mowa o blokadzie 30, 60, 90, 120, 144, czy 300 klatek na sekundę, które pozwalają m.in. obniżyć obciążenie sprzętu przy np. graniu na 60-Hz monitorze przy odświeżaniu 500 FPS.

Wprawdzie takie sytuacje zwiększają responsywność w grach, ale właściciele monitorów z wbudowanym modułem G-Sync, G-Compatible, czy FreeSync o słabszych parametrach zapewne wiedzą, jak ważne jest utrzymanie np. poziomu 90 Hz, aby utrzymać działanie FreeSynca. Dodatkowo takie ograniczenie pozwala się pozbyć efektu “rozrywania ekranu”.

Pole widzenia w grach

Wielu uzna, że Field of View (pole widzenia) ma więcej wspólnego z opcjami umieszczanymi w menu “Rozgrywka”, a nie “Ekran”, ale to opcja wpływająca na płynność gry, więc warto ją tutaj umieścić. Jej działanie jest proste i każdy zagorzały fan gier nastawionych na rywalizacje z pewnością korzystał z niej nie raz. Zmiana pola widzenia w grach pozwala nam widzieć mniej lub więcej względem tego, co ustalili deweloperzy.

Jednak chcąc “widzieć więcej” musimy przygotować się na spadek wydajności, bo wirtualny świat, na którego spoglądamy wcale nie jest renderowany na bieżąco w najmniejszych szczegółach. Silniki graficzne operują na zasadzie renderowania w danym momencie tego, na co patrzy gracz, pozostawiając elementy w tle w bardzo niskiej jakości. Zwiększając pole widzenia, zmuszamy tym samym nasz sprzęt do generowania większej części obrazu, a to (podobnie jak w przypadku rozdzielczości), wywiera na niego dodatkowe obciążenie.

Tryb wyświetlania w grach

Pełny ekran, okno i okno bez ramki – te trzy opcje są zwykle spotykane w grach i odpowiadają za to, jak system je traktuje. W większości przypadków najlepiej postawić na “Pełny Ekran”, który gwarantuje, że Wasze zasoby sprzętowe będą skupiać się na grze, pozostawiając aplikacje i procesy w tle na dalszym planie.

Staje się to jednak problemem, kiedy korzystacie z wielu monitorów, bo Pełen Ekran blokuje kursor w samej grze. Wtedy jedyną opcją na szybkie przeskakiwanie między aplikacjami (np. przeglądarką i grą) wymaga zastosowania np. kombinacji Alt+Tab, a to może nawet skończyć się awarią gry.

Tryb HDR w grach

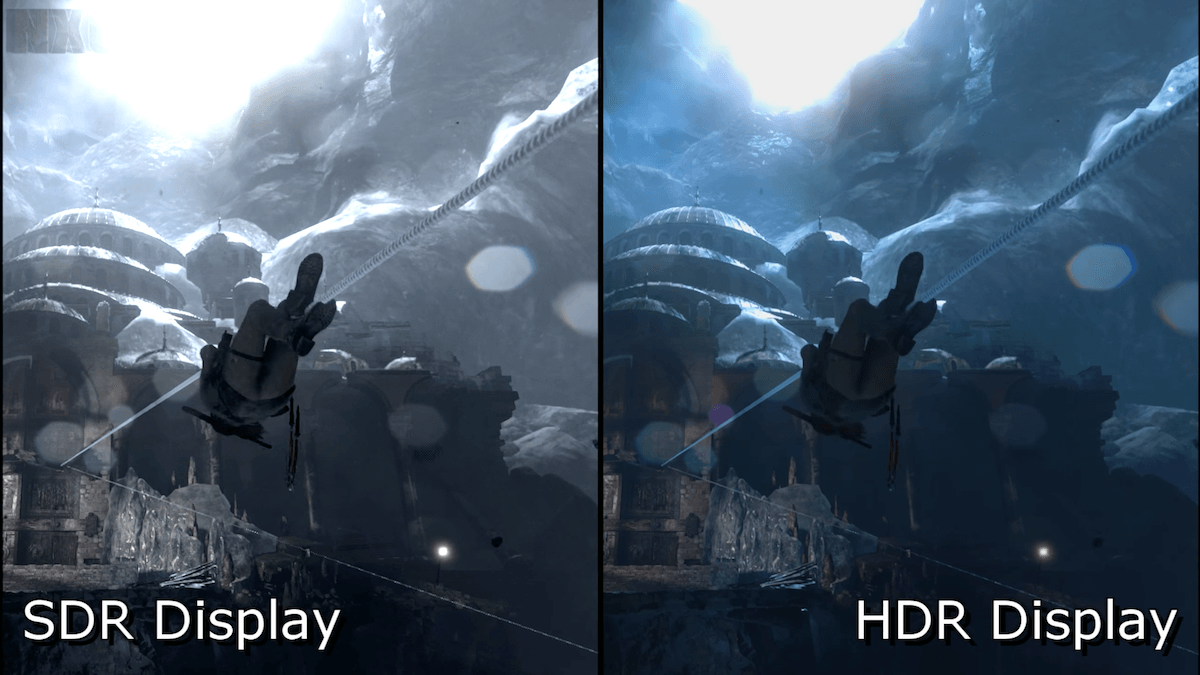

Kolejną opcją “dla nielicznych”, bo tylko tych, którzy mają dostęp do ekranów z High Dynamic Range, jest właśnie ustawienie HDR. Zwykle możemy je albo wyłączyć, albo włączyć i koniecznie warto zadbać o to, aby rzeczywiście było włączone, bo pozwala wydobyć dodatkową jakość z obrazu (nadać mu głębi, charakteru), co widać zwłaszcza w najciemniejszych lub najjaśniejszych fragmentach sceny. Tam HDR pozwala wyrenderować natężenie światła wykraczające poza zakres możliwy do osiągnięcia na ekranie monitora.

API DirectX w grach

DirectX, to towarzyszące nam od dekad API (określa pewne standardy i sposób komunikowania się ze sobą programów), które na ten moment w najnowszej wersji przyjmuje postać DirectX 12 Ultimate, czyli ulepszenia DirectX 12 z 2015 roku, które wprowadziło funkcję RayTracingu, Variable Rate Shading i Mesh Shaders. Jednak nadal gry powstają z myślą również o DirectX 11 i pozwalają nawet dowolnie wybierać, czy wolimy, aby dana gra działała na nowszym, czy starszym API.

Czasem nie mamy oczywiście wyboru i przy korzystaniu z najnowszych technologii jesteśmy zmuszeni do DirectX 12. Prowadzę tutaj narrację, jakby było to problemem, co nie jest przypadkiem, bo pomimo bardziej nowoczesnego standardu, znamy wiele przypadków, w których DirectX 11 pozwalał wyciskać więcej FPSów, niż DirectX 12 w grach. To jednak zależy od sprzętu i danej gry, więc sami musicie zweryfikować, które API będzie dla Was odpowiednim wyborem. Szybki test porównawczy w wbudowanych benchmarkach zwykle zapewnia odpowiedź.

V-Sync, czyli synchronizacja pionowa w grach

V-Sync, to jedna z tych technologii, która ma swoje złe i dobre strony. Z jednej strony dzięki niej możemy pozbyć się “rozdarcia obrazu”, czyli momentu, w którym monitor wyświetla dwie klatki w jednym momencie, zamiast jednej. Widać to zwłaszcza przy dynamicznych scenach, czy szybkim ruchu kamery, co jest spowodowane znacznie wyższą liczbą FPS względem odświeżania monitora.

Dokonuje się tego poprzez zsynchronizowanie monitora z kartą graficzną, co z miejsca ogranicza liczbę FPSów do poziomu odświeżania monitora (wyrażonego w Hz). Ma to jednak swoje złe strony, bo tak sztuczne wymuszenie sprawia, że w razie spadku FPS poniżej konkretnego poziomu (np. 60) V-Sync zmniejsza płynność obrazu bardziej, niż w momencie, gdyby pozostał dezaktywowany.

Dodatkowo V-Sync wprowadza duży input-lag, czyli opóźnienie reakcji gry na nasze ruchy (kliknięcie w klawiaturę, czy ruch myszką), co czyni go bezużytecznego w przypadku gier dynamicznych. Zwłaszcza jeśli gra pozwala ograniczyć FPSy do poziomu Hz monitora – wtedy V-Sync staje się już zupełnie zbędny.

Warto jednocześnie pamiętać też o opcji Adaptive V-Sync i Enhanced Sync, która wyeliminowała przynajmniej problem związany ze spadkiem klatek. Są to jednak już przestarzałe rozwiązania (w przypadku nowych PC), bo miano najlepszych rozwiązań na problemy z rozrywaniem obrazu należy się nowoczesnej technologii G-Sync od NVIDIA oraz FreeSync od AMD. Te eliminują problemy V-Sync, gwarantując jednocześnie całkową ochronę przed screen-tearingiem.

Pojedyncze, podwójne lub potrójne buforowanie w grach

Po rozpowszechnieniu się G-Sync i FreeSync problemy wyświetlania kolejnych klatek na ekranie pozostały tak naprawdę przeszłością. Jednak ciągle w grach znajdziemy opcje związane z podwójnym i potrójnym buforowaniem, które mają bezpośredni związek właśnie z synchronizacją pionową.

O co więc dokładnie chodzi? O ile spolszczona wersja technologii nie jest aż tak jednoznaczna, to z angielskiego Double- i Triple-Buffer jasno wskazuje, że w grę wchodzi postawienie na “zapas” wyświetlania kolejnych klatek obrazu w pamięci VRAM. W przypadku obu podejść aktualnie wyświetlana klatka obrazu nazywana jest “przednim buforem”, a ta, która ma zostać wyświetlona następnie “tylnym buforem”, nad którym pracuje rdzeń graficznym.

Działa to tak, że bufory zwyczajnie zamieniają się miejscami, kiedy nadejdzie na to odpowiedni moment (otrzymają rozkaz od V-Sync). W przypadku potrójnego buforowania w grę wchodzą dwa tylne bufory, z czego jeden z nich pełni poniekąd funkcję tego “awaryjnego”. W tym przypadku monitor może wyświetlać określoną klatkę, a karta graficzna pracować zamiennie nad dwoma kolejnymi i kiedy nadejdzie odpowiedni moment, podmienić tę najnowszą.

Jak łatwo sobie wyobrazić, takie podejście do renderowania obrazu obciąża sprzęt bardziej, ale tutaj Was zaskoczę. Nawet w tych grach, w których nie znajdziecie tej opcji, te dwie technologie mogą działać w tle. Zapewniają to sterowniki graficzne, bo obecnie nawet NVIDIA i AMD nie zaleca producentom gier implementacji tych funkcji na własną rękę i skorzystanie z tych wbudowanych.

Poziom detali, jakość tekstur, cieni, oświetlenia… a tak naprawdę jakość “wszystkiego” w grach

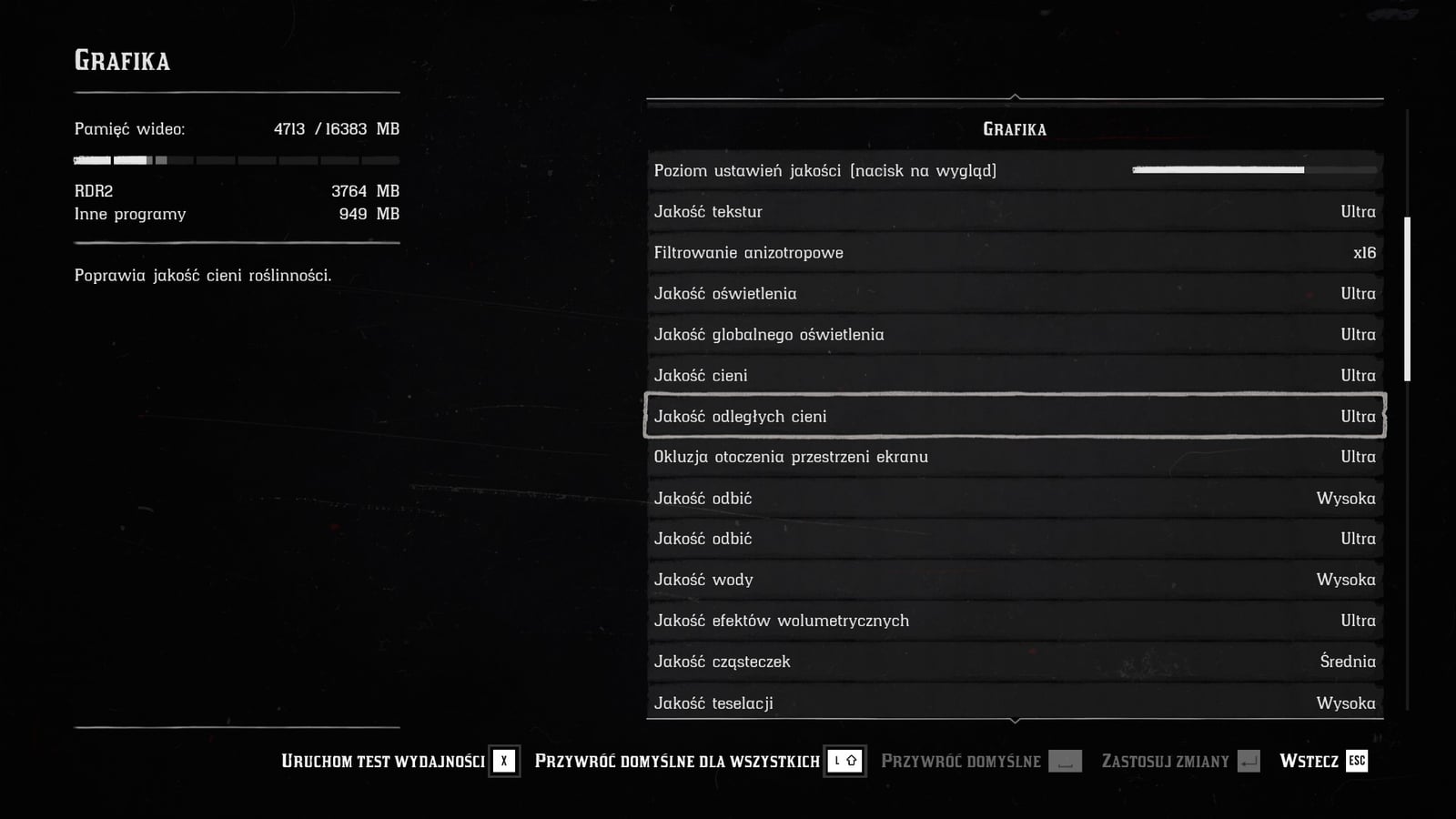

Kwestię ustawień “jakości” zdecydowanie najlepiej obrazuje przykład z menu Red Dead Redemption 2:

Zwykle “jakość” jest sprowadzona do tekstur, roślinności i cieni, czy oświetlenia ale RDR2 poszedł w zupełnie niespodziewanym kierunku i pozwala dostosować nawet jakość… praktycznie wszystkiego. To dobrze, bo jeśli ktoś jest wodomanem albo trawomanem w grach, może ustawić sobie te właśnie ustawienia na najwyższy poziom i cieszyć się szczegółową taflą wody, źdźbłami traw, czy drzewami.

To ustawienie bezpośrednio dotyczy tego, jak “ładne” będą poszczególne elementy. Sprowadza się to do gęstości roślinności w świecie gry, bardziej szczegółowych i realistycznych cieni, czy efektów, odciskając piętno przede wszystkim na pamięci VRAM, której wyższe wymagania potrzebują po prostu więcej.

Nie bez powodu jest to jednak oddzielnym ustawieniem jest poziom detali. Ten odpowiada za to, jak szczegółowe są renderowane obiekty z danej odległości i tak im wyższe ustawienie, tym większa odległość, z której poziom detali zaczyna maleć, a jeśli już przy tym jesteśmy…

Czytaj też: CES 2022 – nie tak powinno wyglądać święto elektroniki

Zasięg widoczności, czyli odległość renderowania w grach

Niech pierwszy rzuci kamieniem ten, na kogo oczach nie pojawiły się choć raz budynki, lasy, a nawet całe wzgórza. Te tak zwane graficzne “pop-upy” występują zawsze wtedy, kiedy silnik graficzny “musi” wyrenderować dany obiekt na oczach gracza, bo akurat ten znalazł się wystarczająco blisko. To coś w stylu “sorry graczu, mam to wpisane do excela, więc teraz patrz na magię”. Przykład tego możecie obejrzeć poniżej w rozbudowanym świecie, ale takie problemy występują nawet w grach wyścigowych przy wysokich prędkościach.

Tego typu artefakty graficzne są bezpośrednio związane z odległością renderowania. Jak wspominałem w przypadku pola widzenia, gra “pokazuje” nam tylko to, co mamy zobaczyć w dążeniu do oszczędzania zasobów sprzętowych. Sprawa ma się podobnie w przypadku odległych obiektów, bo choć te majaczą na horyzoncie zawsze, to odległość dzieląca naszą postać od nich jest na tyle duża, że można znacznie je uprościć, a gracz nawet tego nie zauważy. Chyba że zablokuje postać w miejscu i ruszy w świat na “free-camie”.

W idealnym świecie, gry zawsze renderowałyby się w najmniejszych szczegółach, ale przez ograniczenia deweloperzy muszą zadbać o to, aby graficzne elementy z odpowiedniej odległości traciły na szczegółowości. To, w jakim stopniu będzie to zachodzić, zależy zwykle od nas i suwaka, który pozwala dostosować odległość renderowania. Zwykle dotyczy on szczegółów tła, co sprawia, że kiedy zagramy w coś z tą opcją ustawioną na najniższy poziom, będziemy mieć wrażenie, że świat “ożywa” wyłącznie wokół nas. Pozwala to jednak znacznie podbić liczbę FPSów.

Zaawansowane opcje graficzne w grach

Antyaliasing w grach

Jak już wspominałem, widziany przez nas obraz jest zbudowany z pikseli. Maleńkich kwadracików, które wspólnie zaczynają tworzyć na ekranie nawet obłe kształty. Problem pojawia się wtedy, kiedy renderowana grafika nie jest w stanie zapewnić tym pikselom odpowiedniej informacji (co do wyświetlanego koloru), co objawia się przerywanymi liniami skośnymi, czy poszarpanymi krawędziami. Te zjawiska określa się mianem “aliasingu”, więc opcje “antyaliasingu” z oczywistych względów z nimi walczą.

W idealnym świecie poszarpane krawędzie wyeliminowałoby renderowanie obrazu w odpowiednio wysokiej rozdzielczości. Jak już jednak wspomniałem na samym początku, renderowanie czegokolwiek w grze w wyższej rozdzielczości zawsze wymaga ogromnych mocy obliczeniowych. Zjawiska aliasingu można zwalczać skalowaniem z wyższych rozdzielczości do niższych (ma to sens głównie w mniej wymagających grach), stosowaniem technik super rozdzielczości (np. DLSS), czy znacznie częściej metodami antyaliasingu:

- Antyaliasing w formie przetwarzania końcowego

- FXAA

- TXAA

- SMAA

- MFAA

- MLAA

- Antyaliasing przestrzenny

- MSAA

- SSAA

- FSAA

Lata rozwoju tej technologii wyselekcjonowały najskuteczniejsze i/lub najwydajniejsze z nich, bo każda z wymienionych technik różni się w pewnym stopniu od siebie. Ich efektem jest jednak to samo – pobierają próbki koloru pikseli (zwykle 2, 4 lub 8) wokół danego obiektu, wyciągają z nich średnią (najbardziej odpowiadający kolor) i to właśnie jego dany piksel wyświetla, co w połączeniu z pozostałymi, pozwala uzyskać mniej poszarpane krawędzie.

Chociaż skuteczność tych opcji różni się od sprzętu i gry, zwykle najlepiej postawić na FXAA, o ile gry w ogóle udostępniają taką opcję, bo często korzystają z niego już w natywny sposób. Nie bez powodu, bo ma tylko niewielki wpływ na poziom FPSów, a na dodatek świetnie radzi sobie z problemem, choć jest to tylko filtr, który tylko wpływa na końcowy, wyrenderowany już obraz.

Filtrowanie tekstur w grach, czyli anizotropowe, bilinearne i trójliniowe

Wcześniej wspominałem o odległości renderowania, która brała pod uwagę najważniejsze i od razu rzucające się w oczy elementy krajobrazu, więc samo filtrowanie tekstur można uznać za brata tej głównej opcji. Jak już wspomniałem, ciężko wymagać od naszego sprzętu, żeby renderował cały świat gry w najwyższej rozdzielczości. Dlatego silniki gry pozwalają sobie obniżyć jakość obiektów oddalonych od nas odpowiednio daleko, aby spadek jakości nie był aż tak odczuwalny.

Wykorzystuje się do tego tak zwane mipmapy, czyli te same tekstury, ale generowane w niższej rozdzielczości, których jakość również można poprawić. To je bierze na celownik opcja filtrowania tekstur, która obejmuje filtrowanie bilinearne, trójliniowe i anizotropowe. Ta pierwsza (najprostsza) generuje piksele na podstawie czterech otaczających go próbek/pikseli. Druga jest tego rozwinięciem, uwalniającym obraz od ostrych przejść, dzięki uwzględnianiu w tym rachunku również dwóch mipmap wokół.

Zdecydowanie najskuteczniejsze jest najnowsze filtrowanie anizotropowe z ustawieniami w kolejnych potęgach dwójki, czyli x2, x4, x8, czy x16, które znacząco poprawiają jakość oddalonych obiektów przy jednocześnie prawie zerowym wpływie na płynność. Wspomniane cyfry i liczby określają natężenie działania tej funkcji, którą możemy uznać za rozwinięcie filtrowania trójliniowego, bo do równani dorzuca dodatkowo kąt, pod którym patrzymy na tekstury. Efekty tego widać zwłaszcza na powierzchni, po której stąpamy w wirtualnych światach.

Wolumetryczne efekty w grach

Te ustawienia, mogące dotyczyć mgły, chmur i oświetlenia, to spora nowinka na rynku, która w Assassin’s Creed: Odyssey pożera sporą część zasobów procesora, aby… wyrenderować bardziej realistyczne chmury. Realizowane jest to poprzez symulacje oświetlania rozproszonych cząsteczek, co widać nawet przy kurzu unoszącym się w nieodwiedzanym od tysiącleci grobowcu.

Głębia ostrości w grach

Z tej opcji korzysta każdy, nawet nie zdając sobie z tego sprawy. Wszystko rozbija się o to, jak i co w danej scenie jest wyostrzone. Może to być wszystko, ale też jeden konkretny element albo część krajobrazu, co zwykle jest wykorzystywane do budowania narracji podczas cut-scenek, czy zwracania naszej uwagi na coś szczególnego.

Podczas rozrywki ma za zadanie rozmazywać obiekty znajdujące się w oddali, czy blisko, ale na skraju obrazu (w zakresie widzenia peryferyjnego) chcąc “udawać”, że nasza wirtualna kamera, to tak naprawdę nasze oczy. Co ciekawe, jej aktywowanie wbrew pozorom zwykle generuje wyższe obciążenie karty graficznej.

Ambient Occlusion w grach

Jako że w grach zachowanie światła jest ciągle realizowane przede wszystkim sztucznie, powstało wiele technik, które poprawiają finalny efekt próby naśladowania naszego rzeczywistego świata. Jedną z opcji, którą deweloperzy nadal implementują w ustawieniach graficznych, jest funkcja Ambient Occlusion, zaliczająca się i tak do ogólnego zbiorku technik Global Illumination i nawet NVIDIA RTX.

Ambient Occlusion odpowiada za jeszcze bardziej realistyczne cieniowanie obiektów, a dokładniej mówiąc, bierze pod uwagę wirtualne rozproszone światło, szacując stopień zacieniowania danych elementów. Przykładem tego może być np. wielkie pudło, którego dno przy nikłym świetle jest ciemniejsze względem ścianek. Wpływa nieco na wydajność w przypadku technologii BTAO, a zwłaszcza HBAO+, ale zauważalnie poprawia głębię obrazu.

Czytaj też: Intel wycina siłą instrukcje AVX-512 z platform Alder Lake. Czy jest czego żałować?

Poświata, czyli Bloom w grach

Kolejny post-process, który był nadużywany zwłaszcza przed dwoma dekadami, obejmował dziwne zamiłowanie twórców do skąpania całego świata w miękkim świetle albo próbę oślepienia nas zbyt jasnymi źródłami światła. Jego głównym zadaniem jest zidentyfikowanie najjaśniejszych punktów renderowanej sceny i delikatne rozmycie ich tak, aby stworzyć wokół nich efekt poświaty. Nadal jest spotykany w grach, ale często twórcy pomijają tę opcję, znajdując złoty środek w podstawowych ustawieniach swojej produkcji.

Rozmycie, czyli Blur w grach

Obok efektu Bloom, rozmycie (również to w ruchu), to zwykle opcja, którą wszyscy dezaktywują, aby uwolnić się od rozmytego tła przy ruchu kamerą. Powodem ku temu jest samo jego przeznaczenie – ma imitować rzeczywisty świat, co w grach nie zawsze się sprawdza i na dodatek wpływa na płynność, choć jest to jedynie filtr dodawany na bieżąco. Jednak ten efekt jest świetnym dodatkiem w grach wyścigowych, bo potęguje wrażenie wysokich prędkości.

Wyostrzanie w grach

Obecnie wyostrzanie (sharpening), to głównie opcja powiązana z technologiami super rozdzielczości, ale i np. w Wiedźminie 3 twórcy postarali się o implementacje tego ustawienia w menu. To kolejny już efekt, który ma swoich zwolenników (niewielu) i zagorzałych przeciwników.

Trudno się temu dziwić, bo odpowiada za zwiększenie kontrastu kolorów wzdłuż automatycznie wykrywanych krawędzi, dzięki czemu obraz wygląda na nieco ostrzejszy. Brzmi to nieźle, ale jako kolejny filtr, nie tylko obniża płynność gry, bo na dodatek sprawia, że grafika wydaje się jeszcze bardziej nienaturalna.

DLSS, FSR, Image Scaling i RSR czyli wyższe rozdzielczości niższym kosztem

Po sukcesie technologii DLSS (zwłaszcza w wersji 2.0) AMD stworzyło własny odpowiednik w postaci FSR, na co NVIDIA odpowiedziała Image Scaling, co zmusiło ponownie Czerwonych do reakcji z wykorzystaniem Radeon Super Resolution.

Wszystkie te technologie różnią się działaniem i wymaganiami, ale każda z nich ma jeden cel – wyświetlać na monitorze przeskalowany obraz z niższej rozdzielczości, co znacząco poprawia płynność gry przy zachowaniu wysokiej jakości. Te technologie mają też poniekąd wbudowany w siebie anty-aliasing, zapewniając często nawet wyższą jakość ekranu względem natywnie renderowanego obrazu.

Opcje Ray-Tracingu w czasie rzeczywistym

Wraz z DLSS, przed kilkoma laty w ramach NVIDIA RTX zadebiutowała też funkcja Ray-Tracingu w czasie rzeczywistym, która wymaga nowszych kart graficznych GeForce RTX. AMD również zaczęło implementować w swoich Radeonach RX te specjalne rdzenie i tak też dziś w wielu zaawansowanych grach możemy skorzystać z tej wyjątkowej funkcji.

Innymi słowy, deweloperzy generują tym sposobem sztuczne oświetlenie i choć ciągle sprawdza się to bardzo dobrze, to technologia Ray Tracing jest w tym oczywiście lepsza. Ta całkowicie odmienia sposób generowania oświetlenia w grach, porzucając sztuczność na rzecz realizmu.

Czytaj też: Czym jest NFT? Niewymienialne tokeny mają swoje dobre i złe strony… zupełnie jak kryptowalut

Twórcy gier od dawna bazują na tak zwanej rasteryzacji przy projektowaniu oświetlenia. W jego ramach powierzchnie każdego obiektu są cieniowane na podstawie ich właściwości materiału i padającego na nie światła. Dokonuje się tego poprzez imitację naturalnego światła w oparciu o “wystrzeliwane” ze źródeł światła promienie w czasie rzeczywistym, co pozwala generować m.in. wyższej jakości cienie i odbicia.

Omawiając Ray Tracing nie sposób nie wspomnieć, że niestety te efekty odbijają się na ogólnej wydajności i spadki klatek na sekundę z tą technologią często obniżają płynność na wyższych rozdzielczościach do poziomów nie do przyjęcia. Więcej na jej temat przeczytacie w naszym specjalnym artykule, wyjaśniającym jej tajemnice.