Rozwój i użytkowanie sztucznej inteligencji wiąże się z dużym zapotrzebowaniem na energię elektryczną. Właściwie od samego początku jej użytkowania jest to problem, nad którym pracują inżynierowie na całym świecie. I właśnie pojawiło się pierwsze rozwiązanie, które może przynieść wymierne korzyści.

CRAM – droga do oszczędności energii?

Naukowcy zaprojektowali nowy prototypowy układ “obliczeniowej pamięci o dostępie swobodnym” – CRAM, czyli “computational random-access memory”. Jak wykazały testy, może zmniejszyć zapotrzebowanie na energię w zastosowaniach SI nawet o 1000 razy… lub więcej! W jednej z przeprowadzonych symulacji technologia CRAM wykazała niesamowitą, 2500-krotną oszczędność energii.

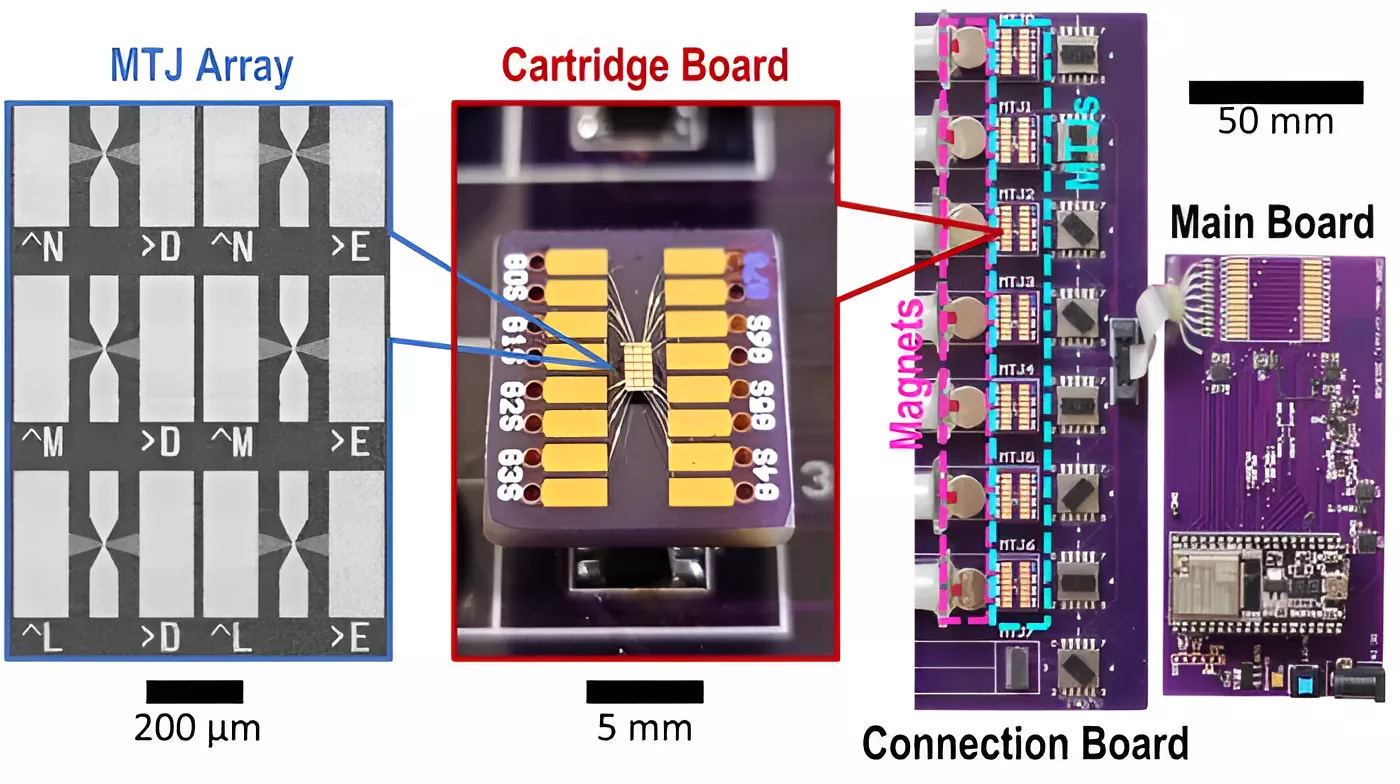

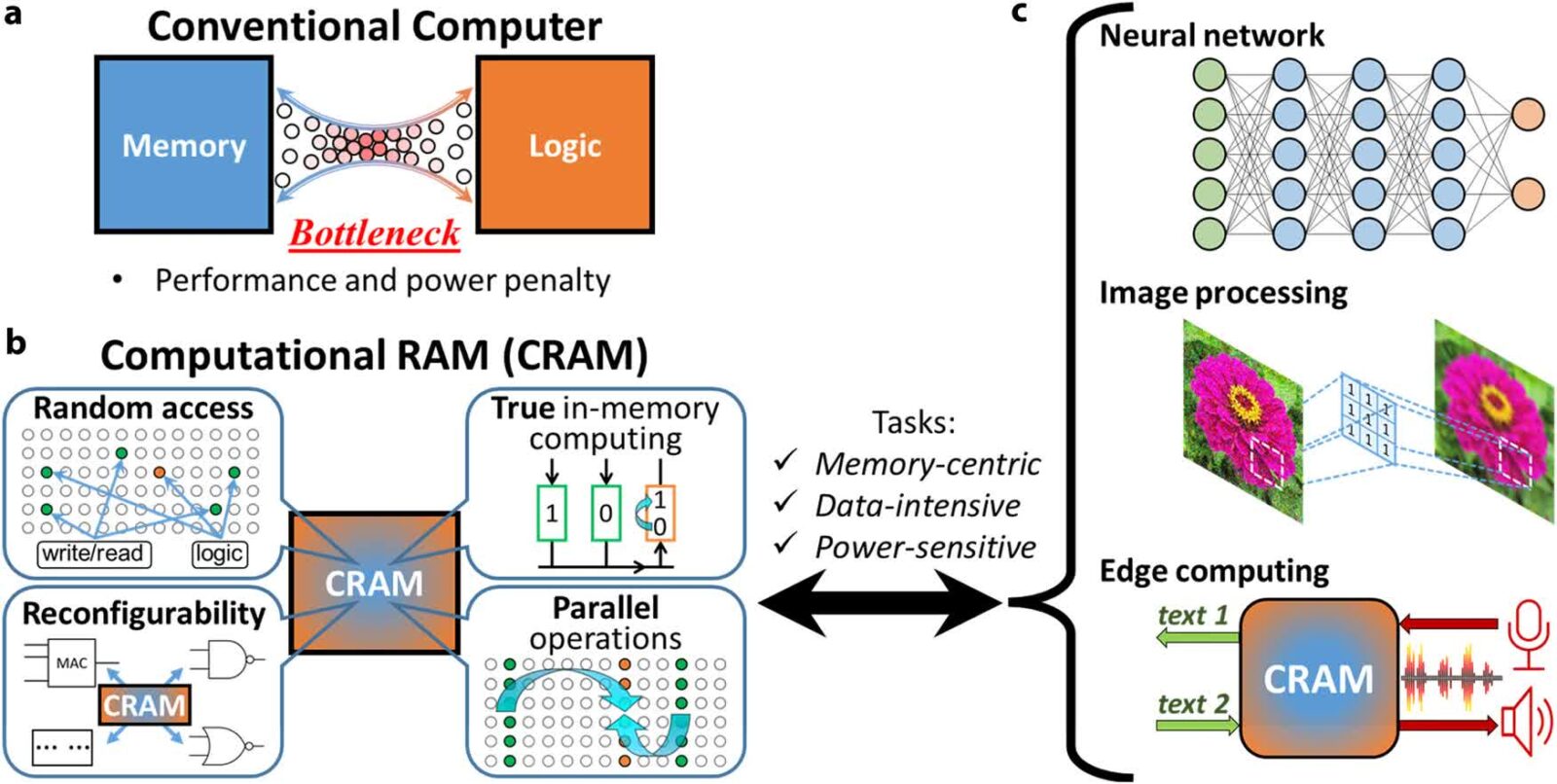

Tradycyjne obliczenia opierają się na istniejącej od kilkudziesięciu lat architekturze von Neumanna, składającej się z oddzielnych jednostek procesora i pamięci, co wymaga ciągłego przesyłania danych tam i z powrotem w ramach procesu, który pochłania energię. Rozwiązanie CRAM całkowicie zmienia podejście do zagadnienia – obliczenia wykonuje się bezpośrednio w samej pamięci za pomocą urządzeń spintronicznych, zwanych “magnetycznymi złączami tunelowymi” (MTJ – magnetic tunnel junctions).

Czytaj też: Sztuczna inteligencja zacznie kierować pociskami. Europejska firma stworzyła Orchestrike

Urządzenia spintroniczne wykorzystują spin elektronów, oferując bardziej wydajny substytut tradycyjnych chipów opartych na tranzystorach i ładunkach elektrycznych do przechowywania danych. Ulya Karpuzcu, współautorka artykułu opublikowanego w Nature, wyjaśnia:

Jako niezwykle energooszczędny, cyfrowy substrat obliczeniowy w pamięci, CRAM jest bardzo elastyczny, ponieważ obliczenia można wykonywać w dowolnym miejscu macierzy pamięci. W związku z tym możemy rekonfigurować CRAM, aby najlepiej odpowiadał potrzebom wydajnościowym zróżnicowanego zestawu algorytmów AI

Eliminując energochłonne transfery danych między logiką a pamięcią, technologia CRAM może mieć kluczowe znaczenie dla zwiększenia efektywności energetycznej sztucznej inteligencji w czasach, gdy jej zapotrzebowanie na energię gwałtownie rośnie. Międzynarodowa Agencja Energetyczna prognozowała w marcu, że globalne zużycie energii elektrycznej na potrzeby szkoleń i zastosowań sztucznej inteligencji może wzrosnąć ponad dwukrotnie, z 460 TWh (terawatogodzin) w 2022 r. do ponad 1000 TWh do 2026 r. – czyli prawie tyle, ile zużywa cała Japonia.

Technologia CRAM nie powstała z dnia na dzień. Jest efektem ponad dwudziestu lat pracy, a podstawą są badania profesora inżynierii Jian-Ping Wanga nad wykorzystaniem nanourządzeń MTJ do celów obliczeniowych. Oczywiścieto dopiero początek i są jeszcze liczne wyzwania związane ze skalowalnością, produkcją i integracją z istniejącym krzemem. Ale już w planach jest współpraca z liderami branży półprzewodników, aby pomóc w umożliwieniu komercyjnego wykorzystywania nowej technologii.